虚拟机安装hadoop教程,虚拟机环境下Hadoop的安装与配置详解

- 综合资讯

- 2025-03-15 21:55:06

- 2

本教程将详细介绍如何在虚拟机环境中成功安装和配置Hadoop,我们将从准备阶段开始,包括选择合适的操作系统、下载并安装必要的软件包等,我们会深入探讨Hadoop的核心组...

本教程将详细介绍如何在虚拟机环境中成功安装和配置Hadoop,我们将从准备阶段开始,包括选择合适的操作系统、下载并安装必要的软件包等,我们会深入探讨Hadoop的核心组件及其功能,如名称节点(NameNode)、数据节点(DataNode)和工作节点(TaskTracker),我们还将介绍如何配置网络设置以确保各个节点之间的通信顺畅无阻,我们将通过实际操作来验证我们的配置是否正确无误,并对可能出现的问题进行排查和处理,通过完成本教程的学习,您将能够独立地在虚拟机上部署和管理一个高效的Hadoop集群。

在当今大数据时代,Hadoop作为一种开源分布式计算平台,因其强大的数据处理能力而备受青睐,对于初学者或需要快速部署环境的人来说,如何在虚拟机上成功安装和配置Hadoop可能是一项颇具挑战的任务,本文将详细介绍在虚拟机中安装Hadoop的具体步骤,并结合实际操作经验,为读者提供一个全面的指南。

准备工作

选择合适的虚拟化软件

目前市面上流行的虚拟化软件包括VMware Workstation、VirtualBox等,考虑到性能和兼容性,这里推荐使用VMware Workstation Pro,它支持多种操作系统,且提供了丰富的网络配置选项,非常适合搭建Hadoop集群。

确定硬件资源

为了确保Hadoop能够正常运行,建议至少配备以下硬件条件:

- CPU:双核及以上,最好是四核或更多;

- 内存:8GB及以上,最好能达到16GB以上;

- 磁盘空间:至少100GB,用于存储数据文件和日志信息。

安装操作系统

选择一个稳定的Linux发行版作为宿主机的操作系统,如Ubuntu Server、CentOS等,这些系统都具有良好的社区支持和广泛的开发工具库。

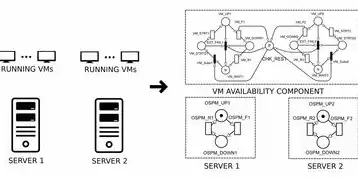

图片来源于网络,如有侵权联系删除

安装Java Development Kit (JDK)

Hadoop是基于Java开发的,因此必须先安装JDK,以下是安装JDK的一般步骤:

-

下载JDK:访问Oracle官网下载最新版本的JDK(注意遵守相关许可协议)。

-

解压安装包:将下载好的压缩包解压到指定目录下。

-

设置环境变量:

- 编辑

~/.bashrc文件,添加如下内容:export JAVA_HOME=/path/to/jdk export PATH=$PATH:$JAVA_HOME/bin

- 重启终端以使更改生效。

- 编辑

-

验证安装:执行

java -version命令检查是否成功安装了JDK。

下载并安装Hadoop

接下来是Hadoop的核心部分——下载和安装Hadoop本身。

-

获取源代码:从Hadoop官方网站下载最新稳定版本(例如3.x系列),可以选择tar.gz格式的二进制发布包或者源码包进行编译安装。

-

解压文件:将下载后的压缩包解压至宿主机上的某个路径下,例如

/usr/local/hadoop。 -

配置环境变量:

- 在

~/.bashrc中添加以下行来设置HADOOP_HOME和HADOOP_CONF_DIR:export HADOOP_HOME=/usr/local/hadoop export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export PATH=$PATH:$HADOOP_HOME/bin

- 同样地,重启终端以确保环境变量的更新。

- 在

-

创建默认配置文件:由于我们还没有具体的配置文件,可以先用一个空的

core-site.xml和hdfs-site.xml作为占位符:

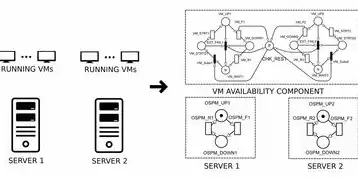

图片来源于网络,如有侵权联系删除

<!-- core-site.xml --> <configuration> </configuration> <!-- hdfs-site.xml --> <configuration> </configuration>

-

启动NameNode和DataNode服务:

- 执行

start-dfs.sh脚本启动HDFS服务:$ hadoop-daemon.sh start namenode $ hadoop-daemon.sh start datanode

- 查看状态:

$ jps

- 执行

-

测试HDFS功能:

- 创建一个测试文件夹并在其中写入一些数据:

$ hadoop fs -mkdir /user/test $ hadoop fs -put localfile.txt /user/test/

- 验证数据是否已正确保存:

$ hadoop fs -ls /user/test

- 创建一个测试文件夹并在其中写入一些数据:

配置Hadoop集群

在实际生产环境中,通常会构建多个节点组成的Hadoop集群,下面简要介绍如何配置多节点Hadoop集群的基本流程:

-

网络规划:合理分配IP地址和网络掩码,确保所有节点之间可以通过PXE或DHCP等方式自动获得IP地址。

-

同步时间:通过NTP服务或其他方式保持集群内各节点的时钟一致。

-

共享存储:如果需要跨节点共享数据,可以考虑使用NFS、GlusterFS等分布式文件系统来实现。

-

安全策略:实施适当的安全措施,比如启用Kerberos认证、限制访问权限等。

-

监控与管理:部署如Ambari这样的管理平台来监控和管理整个集群的健康状况和工作负载。

常见问题及解决方法

无法启动HDFS

本文链接:https://www.zhitaoyun.cn/1808258.html

发表评论