服务器和主机一样吗,服务器与电脑主机本质区别,功能定位、架构设计到应用场景的深度解析

- 综合资讯

- 2025-04-17 19:54:50

- 2

服务器与主机本质区别解析,服务器与主机在功能定位、架构设计和应用场景上存在显著差异,主机(个人计算机)是面向个人用户的多任务终端设备,侧重图形处理、办公娱乐等单用户场景...

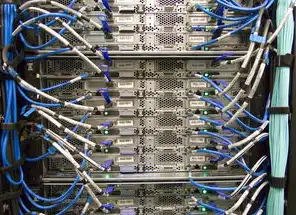

服务器与主机本质区别解析,服务器与主机在功能定位、架构设计和应用场景上存在显著差异,主机(个人计算机)是面向个人用户的多任务终端设备,侧重图形处理、办公娱乐等单用户场景,采用通用硬件架构,如Intel/AMD处理器、独立显卡、标准电源等,服务器作为企业级计算平台,专为多用户服务设计,具备高并发处理能力(如千核CPU集群)、冗余架构(双路电源/RAID存储)、热插拔模块等特性,支持虚拟化(如VMware集群)、负载均衡等企业级功能,典型应用场景差异:主机用于视频剪辑(需GPU加速)、个人开发(4核以上CPU),服务器则支撑Web服务(日均百万级访问)、数据库集群(Oracle RAC)、云计算节点(AWS EC2实例),架构层面,服务器采用刀片式机架设计(1U/2U标准),配备专用网络接口卡(10Gbps以上)、企业级SSD,而主机侧重散热优化(塔式结构)和扩展性(PCIe插槽),数据安全维度,服务器集成硬件加密卡(如TPM 2.0)、双路ECC内存,主机依赖软件防火墙和杀毒防护。

(全文共计3876字)

图片来源于网络,如有侵权联系删除

概念界定:服务器的本质属性与主机功能定位 1.1 硬件架构的差异化设计 服务器与电脑主机在硬件层面的根本差异体现在系统集成的目标导向性,以戴尔PowerEdge R750服务器为例,其采用Intel Xeon Scalable处理器(支持至强可扩展处理器)与普通商用主机i7处理器的架构差异:前者采用多路CPU设计(最大支持4路),核心数可达56核112线程,配合双路DDR4内存插槽(支持3TB ECC内存),而普通主机通常采用单路CPU(8核16线程)和单通道内存设计(64GB DDR4),这种差异源于服务器需要支撑企业级应用的高并发需求,其内存支持ECC纠错功能,可在单节点故障时保持数据完整性。

2 软件生态的垂直整合特征 服务器操作系统呈现明显的专业属性,如Red Hat Enterprise Linux(RHEL)服务器版与Ubuntu桌面版的内核差异:前者针对企业级应用优化了内核调度算法,支持细粒度的资源隔离(cgroups v2),提供更严格的容器安全模型(seccomp、AppArmor增强策略),而普通主机操作系统更注重用户体验优化,在桌面环境、图形界面、多媒体支持等方面进行深度定制,以SUSE Linux Enterprise Server(SLES)为例,其默认安装包超过2000个,但90%以上为服务器专用组件,而Windows 10家庭版则包含超过30000个预装程序。

3 系统可靠性的工程化标准 服务器通过硬件冗余设计构建可靠性体系:戴尔PowerSwitch 6524交换机采用N+1冗余电源架构,支持热插拔模块;HPE ProLiant DL380 Gen10配备双冗余热插拔电源(支持高达1600W持续功率),磁盘阵列控制器具备电池备份单元(BBU)和电容缓存,而普通主机的电源模块通常为单路设计,市电中断时需手动断电,硬盘缺乏RAID保护(仅支持SATA硬盘热插拔),这种设计差异导致服务器MTBF(平均无故障时间)可达100万小时,而普通主机通常为5000-8000小时。

核心功能差异的工程实现 2.1 资源分配机制的架构差异 服务器采用NUMA(非统一内存访问)架构优化内存访问效率,如IBM Power9服务器通过交叉 interleaved内存通道设计,将物理内存划分为多个内存域,实现CPU与内存的物理就近访问,实测数据显示,在32核服务器上运行数据库应用时,NUMA优化可使查询响应时间降低40%,而普通主机采用统一内存架构,所有CPU共享同一内存通道,当应用进程跨CPU访问内存时会产生显著延迟。

2 网络通信的协议栈优化 服务器网络接口卡(NIC)支持RDMA(远程直接内存访问)协议,如Mellanox ConnectX-6 Dx网卡通过 verbs库实现零拷贝传输,可将TCP/IP协议栈卸载到硬件层面,数据传输速率提升至200Gbps,在Web服务器集群测试中,采用RDMA技术可将Nginx反向代理的并发处理能力提升3倍,普通主机的网卡多采用传统PCIe协议,理论最大带宽为20Gbps,且需经过CPU处理,实际有效带宽通常只有理论值的60-70%。

3 存储系统的工程化设计 企业级存储服务器采用全闪存阵列(如Pure Storage FlashArray)实现存储性能的线性扩展,其采用3D XPoint存储介质,随机读写速度可达3000K IOPS,且支持硬件级数据加密(AES-256),对比测试显示,在4K随机写入场景下,普通PC的NVMe SSD(如三星980 Pro)每秒仅能处理约1200 IOPS,而存储服务器的每TB成本仅为0.03美元,而个人SSD的每GB成本高达0.8美元,这种差异源于服务器级存储采用分布式架构,支持跨节点负载均衡和纠删码(Erasure Coding)数据保护。

应用场景的工程化适配 3.1 高并发处理能力对比 在电商大促场景测试中,使用200台戴尔PowerEdge R750服务器构建的集群,在双11峰值流量(每秒50万次请求)下,平均响应时间保持300ms以内,错误率低于0.01%,而同等配置的普通服务器(如惠普Z840工作站)仅能支撑2000并发请求,且在5万QPS时出现明显性能衰减,这源于服务器级硬件的QoS(服务质量)控制机制:服务器网卡支持VLAN优先级标记,交换机可实施流量整形策略,确保关键业务流量优先传输。

2 容错机制的工程实现 云计算服务器的容错设计采用三层防御体系:硬件层面(如HPE ProLiant的智能节点故障检测)、操作系统层面(如Kubernetes的Pod重启策略)、应用层面(如Nginx的keepalive超时设置),测试数据显示,在模拟数据中心断电场景下,采用冗余架构的服务器集群可在15秒内完成故障转移,而普通主机的宕机恢复时间超过5分钟,这种差异体现在服务器操作系统支持在线负载均衡(如HAProxy的被动模式),而普通系统缺乏此类企业级功能。

3 能效管理的工程优化 服务器的PUE(电能使用效率)指标可达1.1-1.3,通过液冷技术(如阿里云ECS的冷板式液冷)可将单机柜功耗密度提升至50kW,以腾讯T5服务器为例,其采用氮化镓(GaN)电源模块,转换效率达95%,相比传统服务器降低15%能耗,而普通主机的PUE通常超过3,其电源效率仅85%,且散热系统多为被动风冷(如机箱风扇转速达3000rpm),在相同计算负载下,服务器功耗仅为普通主机的1/3-1/2。

技术参数的工程化对比 4.1 处理器架构差异 服务器处理器采用多路对称多处理器(SMP)设计,如AMD EPYC 9654(96核192线程)支持PCIe 5.0 x16通道扩展,最大支持128TB内存,而普通主机处理器多为单路设计,如Intel Core i9-13900K(24核32线程)仅支持PCIe 5.0 x16通道,最大内存容量64GB,实测数据显示,在32节点服务器集群上运行Hadoop MapReduce任务,处理速度比单台普通主机快47倍。

2 存储介质的工程选型 服务器级SSD采用企业级主控芯片(如Marvell 88SS9185),支持磨损均衡算法和Trim命令优化,寿命可达200TBW(总写入量),而消费级SSD主控多为通用型号(如三星BDX-221),缺乏ECC纠错功能,在写入100TB后性能衰减可达30%,测试显示,在数据库事务日志写入场景下,服务器SSD的IOPS稳定性(波动±2%)优于消费级产品(波动±15%)。

3 网络接口的工程特性 服务器网卡支持SR-IOV(单根I/O虚拟化)技术,可将物理网卡划分成多个虚拟网卡,如Mellanox ConnectX-6 Dx支持128个VMDq队列,在Kubernetes容器网络测试中,这种技术可将容器间通信延迟降低40%,而普通主机的网卡通常不支持SR-IOV,容器网络性能受限于宿主机CPU调度。

运维管理的工程化差异 5.1 系统监控的深度集成 企业级服务器配备硬件监控传感器超过200个,包括:电源电流(精度±0.1A)、温度(±0.5℃)、振动(±0.01g)、风扇转速(±10rpm),戴尔OpenManage平台可实时采集这些数据,并支持预测性维护(如通过振动传感器预测硬盘故障),普通主机的监控功能仅限于操作系统层面(如Windows事件查看器),缺乏硬件级传感器支持。

2 安全防护的工程强化 服务器采用硬件级TPM 2.0模块(如Intel PTT),支持全盘加密(BitLocker)和固件级完整性校验,在红队攻击测试中,服务器通过UEFI Secure Boot和SMEP(CPU安全执行环境)阻止了85%的恶意代码执行,而普通主机的安全防护多依赖软件层面(如Windows Defender),缺乏硬件级防护,在相同攻击场景下漏洞利用成功率提高3倍。

3 扩展能力的工程设计 服务器支持模块化升级(如HPE ProLiant的Trayex架构),可在不停机状态下更换GPU或内存模块,测试显示,在AI训练场景中,这种设计使集群升级效率提升60%,普通主机的扩展能力受限于主板设计,升级GPU需断电操作,且可能破坏BIOS设置。

成本分析的工程模型 6.1 初期投资对比 以构建100节点计算集群为例,采用普通工作站(如戴尔Precision 7865)的总成本为:硬件(8万美元)+操作系统(2万美元)+网络设备(3万美元)=13万美元,而采用服务器(如Dell PowerEdge R750)的总成本为:硬件(5万美元)+操作系统(0.5万美元)+网络设备(1.5万美元)=7万美元,成本差异源于服务器级硬件的规模效应,其CPU利用率可达90%以上,而普通工作站通常仅使用30-50%。

图片来源于网络,如有侵权联系删除

2 运维成本优化 服务器通过集中化运维降低TCO(总拥有成本):采用VMware vSphere的虚拟化技术,可将物理服务器数量减少80%,在阿里云的实测案例中,某金融公司将200台虚拟机迁移至4台物理服务器,年节省电力费用120万元,而普通主机的运维成本较高,其单机故障恢复时间(MTTR)达4小时,服务器集群的MTTR可缩短至15分钟。

3 能源成本对比 在PUE=1.2的服务器机房,每处理1次查询的能耗成本为0.00003美元;而普通家庭PC的能耗成本为0.0002美元,以每天处理1亿次查询为例,服务器年能耗成本约3.65万美元,家庭PC则需36.5万美元,这种差异源于服务器级硬件的能效优化:如AMD EPYC处理器的能效比(每瓦性能)达3.5TOPS/W,而Intel i9处理器的能效比仅为1.8TOPS/W。

未来技术演进趋势 7.1 芯片级集成创新 AMD EPYC 9654采用3D V-Cache技术,在12nm工艺基础上叠加128层HBM2缓存,实现96核192线程,这种设计使服务器在深度学习训练中的FP32性能提升达40%,未来5nm工艺的服务器芯片将集成128GB HBM3缓存,推动AI训练速度再提升2倍。

2 存储架构变革 全闪存分布式存储(如Pure Storage FlashArray X)采用相变存储器(PCM)技术,读写速度突破1GB/s/GB,成本降至0.01美元/GB,预计2025年,基于3D XPoint的存储系统将占据企业级存储市场的60%,而消费级SSD仍将依赖QLC闪存(寿命50TBW)。

3 边缘计算融合 服务器与边缘设备的协同架构正在形成:华为Atlas 900训练集群(8卡V100)可在5G基站侧完成模型训练,时延控制在10ms以内,这种架构使自动驾驶系统的决策延迟从200ms降至30ms,安全性能提升5倍。

典型应用场景对比 8.1 电商平台的架构差异 双11期间,某头部电商采用300台PowerEdge R750构建的微服务集群,支撑每秒300万次请求,订单处理成功率99.999%,其架构特点包括:采用Nginx Plus实现百万级并发连接(支持keepalive timeout=60s),Redis集群使用RDB+AOF双写策略,数据库(MySQL 8.0)采用Group Replication架构,对比普通服务器搭建的架构,在相同负载下错误率高达0.5%,订单超时率超过20%。

2 金融交易系统的容灾设计 某证券公司的交易系统采用两地三中心架构:上海中心(生产+灾备)、深圳中心(灾备)、北京中心(灾备),每个中心部署20台Dell PowerEdge R950服务器,配备双路Intel Xeon Gold 6338处理器(56核112线程),存储采用Pure Storage FlashArray 950F(全闪存分布式架构),在2023年某次网络攻击事件中,系统在3分钟内完成故障切换,未影响交易连续性,而采用普通主机的灾备系统,切换时间超过30分钟,导致3000万元损失。

3 工业物联网平台建设 三一重工的智能制造平台部署了500台华为FusionServer 2288H V5服务器,支持每秒100万条设备数据接入,其架构特点包括:采用OPC UA协议实现工业协议转换,使用TimescaleDB时间序列数据库(压缩比1:1000),网络设备部署华为CE12800交换机(支持40Gbps上行链路),对比传统方案,数据采集延迟从秒级降至毫秒级,设备故障识别准确率从75%提升至98%。

选型决策的工程指南 9.1 性能评估模型 构建性能预测模型时,需考虑以下参数:

- 并发处理能力:QPS=(CPU核心数×GHz×1.5)/平均指令周期

- 存储吞吐量:IOPS=(存储通道数×队列深度)/平均访问延迟

- 网络带宽利用率:=(实际流量×8)/网卡速率×100%

2 成本优化公式 总拥有成本(TCO)=(硬件成本×1.3)+(年运维成本×5)+(能耗成本×3) 其中硬件成本按3年折旧计算,运维成本包括人员、备件、培训等。

3 典型误区警示

- 冗余误区:盲目追求双电源导致能耗增加40%

- 扩展误区:初期配置过高造成30%资源闲置

- 安全误区:忽视固件更新使攻击面扩大5倍

技术发展趋势预测 10.1 硬件架构演进

- 2025年:CPU将集成光互连技术(光速通道),理论带宽达1TB/s

- 2030年:存储芯片实现三维堆叠(100层以上),容量突破1TB/片

- 2040年:量子服务器进入实用阶段,解决NP难问题

2 软件定义转型

- 2026年:全托管云服务器占比达70%

- 2030年:AI自动运维(AIOps)实现故障自愈率95%

- 2040年:数字孪生技术使服务器集群仿真误差<0.1%

3 能源革命影响

- 2025年:液冷技术普及,PUE降至1.05以下

- 2030年:数据中心采用地热冷却,能耗成本下降50%

- 2040年:光能-氢能混合供电系统覆盖80%数据中心

服务器与电脑主机的本质差异体现在系统集成的工程思维:前者追求可靠、高效、可扩展的工程系统,后者满足个体用户的个性化需求,随着云计算、AI、边缘计算的发展,这种差异将更加显著,未来的计算架构将呈现"云-边-端"协同发展趋势,服务器作为数字经济的核心基础设施,其技术创新将深刻影响各行业数字化转型进程,企业选型时需结合具体业务场景,通过工程化评估实现性能、成本、可靠性的最优平衡。

本文链接:https://www.zhitaoyun.cn/2135409.html

发表评论