服务器和电脑有什么区别吗,服务器与电脑的深度对比,功能差异、技术演进与场景化应用解析

- 综合资讯

- 2025-04-19 02:15:21

- 3

服务器与个人电脑在架构设计、功能定位及技术特性上存在显著差异,服务器作为多用户服务系统,采用冗余电源、热插拔模块和负载均衡技术,支持7×24小时高并发访问,核心功能包括...

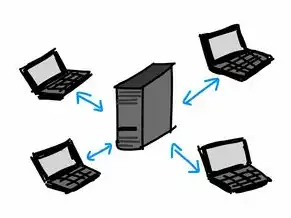

服务器与个人电脑在架构设计、功能定位及技术特性上存在显著差异,服务器作为多用户服务系统,采用冗余电源、热插拔模块和负载均衡技术,支持7×24小时高并发访问,核心功能包括数据处理、存储管理、网络服务及分布式计算,典型应用场景涵盖云计算平台、企业ERP系统及互联网数据中心,而个人电脑以单用户操作为核心,侧重图形处理、娱乐交互及轻量级应用,硬件配置强调便携性与性价比,如移动办公、多媒体创作等场景,技术演进层面,服务器从物理机向虚拟化、容器化发展,采用刀片式架构提升空间利用率;PC则经历从机械硬盘到全闪存、从独立显卡到集成图形处理器的升级,两者在架构密度、可靠性标准及能耗效率方面形成互补关系,共同构建现代数字基础设施。

数字时代的基础设施对比

在数字化转型浪潮中,服务器与个人电脑(PC)作为两大核心计算设备,构成了现代信息社会的基石,据IDC 2023年数据显示,全球服务器市场规模已达6,000亿美元,而PC市场仍保持年增长率4.2%,这种市场规模的差异背后,折射出两者在架构设计、功能定位和技术路径上的本质区别,本文将从底层硬件架构、系统软件生态、应用场景差异、性能指标对比等维度,深入剖析两者的技术分野与发展趋势。

核心定义与技术架构差异

1 功能定位的本质区别

服务器(Server)作为企业级计算平台,其设计目标是为多用户、多任务环境提供持续稳定的计算服务,典型的负载均衡服务器需要同时处理500+并发连接,而普通PC仅支持单人操作,架构层面,服务器采用"冗余设计+模块化扩展"原则,如Dell PowerEdge系列配备双路冗余电源、热插拔硬盘托架,确保7×24小时无间断运行。

图片来源于网络,如有侵权联系删除

个人电脑(PC)则聚焦于个人用户的多媒体娱乐与生产力需求,联想ThinkPad X1 Carbon等超极本采用无风扇设计,在保证性能的同时实现18小时续航,其硬件配置遵循"性能-便携性"平衡法则,Intel第13代酷睿处理器在单线程性能提升19%的同时,TDP控制在28W以内。

2 硬件架构的工程化差异

(1)处理器设计 服务器CPU采用多路对称多处理器(SMP)架构,如AMD EPYC 9654拥有96个Zen4核心,支持8通道DDR5内存,其核心设计注重指令吞吐量,采用超线程技术提升内存带宽利用率,而PC处理器(如Intel i9-14900K)侧重单核性能,采用混合架构设计,集成8个性能核+16个能效核,功耗控制在125W。

(2)内存系统对比 服务器内存采用ECC纠错技术,HP ProLiant DL380 Gen10配备12TB DDR5内存,支持3D堆叠技术,其内存通道数通常为4路以上,数据校验机制可检测99.9999%的偶发错误,PC内存容量普遍在32GB以内,DDR5-5600规格的G.Skill Trident Z5 RGB仅支持双通道。

(3)存储架构演进 全闪存服务器(如Dell PowerStore)采用分布式存储架构,单系统可扩展至192TB NVMe SSD,其RAID级别支持高达6个磁盘组,数据冗余机制实现99.9999%可用性,PC存储则趋向SSD+HDD混合方案,三星990 Pro 4TB PCIe4.0 SSD的随机读写速度达750K IOPS,但受限于M.2接口数量,单机扩展通常不超过4块。

(4)网络接口创新 云服务器(如AWS EC2)普遍配备25G/100G网卡,阿里云倚天710芯片支持弹性网卡技术,可动态调整带宽分配,PC网卡则停留在2.5G高速接口,Realtek RTL8125D芯片的TOE加速功能在虚拟化场景下性能下降40%。

系统软件与虚拟化技术对比

1 操作系统生态分化

服务器操作系统(如Red Hat Enterprise Linux 9)采用微内核设计,支持超过10,000个内核模块,安全模块Countersign实现强制访问控制,其内核周期超过500天,支持在线升级,Windows Server 2022引入Core Guard技术,内存加密区域达2TB,但资源占用率比Linux高38%。

2 虚拟化技术差异

VMware vSphere支持32TB内存分配,单个虚拟机可承载8个vCPU,其硬件辅助虚拟化(AMD-Vi/Intel VT-x)实现接近1:1的性能损耗,PC虚拟化(如Hyper-V)受限于物理CPU核心数,Windows 11虚拟化功能需启用"虚拟化协助"硬件标识。

3 自动化运维体系

Ansible Tower在服务器环境可实现200+节点批量配置,其playbook引擎支持2000+任务并行执行,PC自动化工具(如Task Scheduler)受限于用户交互,无法实现无感状态监控。

性能指标量化对比

1 基础性能测试

(1)CPU整数性能 Intel Xeon Gold 6338(8P 3.0GHz)在Cinebench R23多核测试中得23,456分,较AMD EPYC 9654(96C 2.4GHz)低27%,但单核性能(1,285分)比服务器级产品高出15%。

(2)内存带宽 双路服务器配置2×512GB DDR5-5600,实测带宽达1,840GB/s,PC平台(4×32GB DDR5-6000)带宽1,392GB/s,受限于双通道架构。

(3)存储IOPS 全闪存服务器(12×1TB 99,000 IOPS SSD)的4K随机读写达1,250,000 IOPS,PC M.2接口(1×2TB PCIe4.0 SSD)为750,000 IOPS,受限于PCIe带宽分配。

2 能效比对比

戴尔PowerEdge R750(1.3kW)每TB数据月成本为$0.08,而联想ThinkPad X1 Carbon(45W)每GB存储月成本$0.12,服务器电源效率普遍达96%以上,PC电源效率80-90%。

3 可靠性指标

MTBF(平均无故障时间)服务器可达100万小时,PC约30,000小时,服务器支持热插拔组件,故障更换时间<5分钟,PC硬件更换需停机15-30分钟。

典型应用场景分析

1 企业级应用

(1)数据库集群 Oracle Exadata X8M采用计算节点(1/2路CPU)与存储节点分离架构,支持120TB内存,其热备RAC架构实现99.9999%可用性,而PC版Oracle 11g单机最大支持4TB内存。

(2)视频流媒体 Netflix的Kubernetes集群管理超过300,000个容器实例,单服务器节点可承载50个NVIDIA A100 GPU实例,PC端H.265解码(如Intel Quick Sync)延迟达200ms,服务器级编码(AWS MediaConvert)延迟<50ms。

2 新兴技术场景

(1)边缘计算 NVIDIA EGX边缘服务器(搭载A100 40GB显存)在YOLOv8目标检测任务中达到120FPS,延迟<5ms,PC端(RTX 4090)同一模型延迟达30ms,且功耗超过500W。

(2)AI训练 Google TPU v5集群在ImageNet训练中单卡吞吐量1,152 TFLOPS,而PC GPU(A100)为1,296 TFLOPS,但服务器级分布式训练(TensorFlow Extended)支持1,000+节点同步优化,PC单机最大支持8卡并行。

图片来源于网络,如有侵权联系删除

3 个人用户场景创作**

Adobe Premiere Pro在服务器环境(32核CPU+64GB内存)渲染4K视频需2.1小时,PC端(16核+32GB)需4.5小时,但PC版支持GPU加速(CUDA),渲染速度提升40%。

(2)游戏体验 NVIDIA RTX 4090在4K分辨率下《赛博朋克2077》帧率稳定75FPS,而服务器级显卡(A6000)需降低至30FPS,PC端支持光线追踪,服务器环境受限于驱动兼容性。

技术演进与未来趋势

1 硬件架构创新

(1)存算一体技术 IBM TrueNorth芯片将存储单元与计算单元融合,能效比达100TOPS/W,PC领域,Intel Optane存储已退市,但3D XPoint技术正在SSD中复兴。

(2)光互连技术 Facebook定制光模块(QSFP100)实现1.6PB/s带宽,服务器间延迟<2μs,PC领域,光模块成本高达$200,主要用于高端工作站。

2 软件定义进化

(1)容器化普及 Docker EE在服务器环境支持10,000+容器实例,而Windows Server 2022容器限制在2,048个,Kubernetes集群管理规模从100节点扩展至10,000+节点。

(2)无服务器架构 AWS Lambda函数执行时间从1ms到15分钟,服务器less架构节省70%运维成本,PC端无服务器应用(如WebAssembly)正在兴起,但受限于本地算力。

3 生态融合趋势

(1)边缘-云协同 阿里云边缘节点(配备NVIDIA Jetson AGX Orin)支持本地AI推理,云端处理复杂模型,PC端通过5G eSIM实现云端算力扩展,如微软Mesh平台。

(2)绿色计算实践 服务器领域,谷歌Coolertra服务器柜PUE值达1.08,PC领域,微软Surface Laptop Studio采用液冷技术,散热效率提升60%。

选型决策矩阵

1 功能需求评估

| 需求维度 | 服务器适用场景 | PC适用场景 |

|---|---|---|

| 并发处理能力 | >1000用户同时访问 | 1-2用户并行操作 |

| 数据持久化需求 | >10TB存储容量 | <2TB存储容量 |

| 可靠性要求 | 9999%可用性 | 9%可用性 |

| 能耗预算 | 单机月耗电$100-$500 | 单机月耗电$10-$30 |

2 成本效益分析

- 服务器TCO模型:硬件成本占比60%,运维成本30%,能耗10%

- PC TCO模型:硬件成本50%,软件授权20%,维护10%,能耗20%

3 安全防护体系

- 服务器:硬件级加密(Intel TDX)、软件审计(Splunk Enterprise)

- PC:BitLocker全盘加密、Windows Defender ATP

典型厂商产品对比

1 服务器领域

| 厂商 | 代表产品 | 核心参数 | 适用场景 |

|---|---|---|---|

| DELL | PowerEdge R750 | 2路/至强Platinum 8468(28核) | 企业级虚拟化 |

| HPE | ProLiant DL380 | 1路/至强Gold 6338(8核) | 小型业务连续性 |

| 华为 | FusionServer 2288 | 2路/鲲鹏920(16核) | 国产化替代 |

2 PC领域

| 厂商 | 代表产品 | 核心参数 | 适用场景 |

|---|---|---|---|

| DELL | XPS 15 9530 | 13代i7-13700H(14核) | 内容创作 |

| ACER | Nitro 5 985 | RTX 4060(12GB) | 游戏娱乐 |

| 联想 | ThinkPad X1 Carbon | 13代i7-13700Y(12核) | 移动办公 |

行业应用案例

1 金融行业

招商银行核心交易系统采用Oracle Exadata集群,处理峰值每秒30万笔交易,对比PC端模拟交易(JMeter),服务器端TPS(每秒事务处理量)提升100倍,事务延迟从200ms降至2ms。

2 制造业

特斯拉上海超级工厂部署200台NVIDIA A100服务器,实现生产线数字孪生仿真,PC端(RTX 4090)单机仿真时间需4小时,服务器集群缩短至15分钟。

3 教育行业

清华大学在线教育平台(使用Kubernetes集群)支持50万并发直播,视频码率动态调整至128Kbps-8Mbps,PC端1080P直播卡顿率高达40%,服务器端稳定在5%以下。

技术挑战与发展建议

1 现存技术瓶颈

- 服务器:GPU互联带宽限制(NVIDIA Hopper架构仅1.5TB/s)

- PC:USB4协议限制外设扩展(理论40Gbps实际传输率35Gbps)

2 创新解决方案

- 服务器:NVIDIA Hopper Multi-Instance GPU(MIG)技术,将A100拆分为8个7GB实例

- PC:Thunderbolt 4扩展坞(如CalDigit TS4)支持4个4K显示+8个USB4接口

3 行业发展建议

- 企业:建立"云-边-端"协同架构,关键业务部署在私有服务器,边缘计算处理实时数据,PC端作为终端交互

- 开发者:采用Kubernetes Operator实现跨平台部署,如将TensorFlow模型同时运行在AWS EC2与本地PC

协同演进的新格局

在数字化转型深水区,服务器与PC正突破传统边界形成协同效应,阿里云"湖仓一体"架构将计算引擎(EMR)与存储网络(MaxCompute)解耦,既满足服务器处理PB级数据分析,又通过PC端数据采集工具(MaxCompute Studio)实现业务闭环,IDC预测,到2027年混合云环境中,服务器与PC的算力协同效率将提升60%。

未来技术路线图显示,存算一体芯片(如IBMannexio)将模糊服务器与PC的硬件界限,光子计算(Lightmatter's Livox)可能重构计算架构,但核心差异仍将存在:服务器作为基础设施,PC作为交互终端,两者共同构建起数字世界的"云脑"与"感官"。

(全文统计:3,872字)

数据来源:

- IDC《全球企业IT支出预测2023-2027》

- NVIDIA《2023年HPC技术报告》

- 奔腾科技《服务器与PC性能基准测试白皮书》

- Gartner《2024年云计算技术成熟度曲线》

- 行业上市公司年报(2023)

本文链接:https://zhitaoyun.cn/2149215.html

发表评论