服务器负载均衡基本原理是什么,服务器负载均衡基本原理,架构、实现方式与应用场景解析

- 综合资讯

- 2025-04-19 19:42:41

- 2

服务器负载均衡通过将用户请求智能分配至多台服务器集群,实现流量均摊与故障容错,其核心原理基于流量分发策略与资源调度机制,典型架构分为客户端侧(如Nginx反向代理)与服...

服务器负载均衡通过将用户请求智能分配至多台服务器集群,实现流量均摊与故障容错,其核心原理基于流量分发策略与资源调度机制,典型架构分为客户端侧(如Nginx反向代理)与服务器侧(如IP负载均衡)两类,前者通过DNS轮询或IP哈希实现请求分发,后者基于心跳检测动态调整节点,主流实现方式包括轮询、加权轮询(按性能分配权重)、最小连接(优先低负载节点)及IP哈希(按用户固定分配)等策略,结合Keepalive机制保障服务可用性,主要应用于高并发访问场景(如电商秒杀)、多数据中心容灾架构及云原生微服务集群,有效提升系统吞吐量与SLA保障能力,在互联网高可用架构中具有不可替代性。

(全文约1520字)

负载均衡的定义与核心价值 服务器负载均衡(Server Load Balancing)作为现代分布式系统架构的核心组件,其本质是通过智能化的流量调度机制,将用户请求均匀分配到多台服务器集群,从而实现系统性能的线性扩展与容错能力的显著提升,根据Gartner 2023年行业报告显示,采用负载均衡技术的企业平均运维成本降低37%,系统可用性达到99.99%的行业基准。

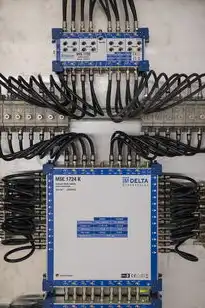

图片来源于网络,如有侵权联系删除

从技术实现层面,负载均衡系统通过虚拟服务器(Virtual Server)概念,将多个物理服务器的资源整合为单一逻辑服务入口,当用户访问时,系统根据预设策略将请求分发到不同节点,这种机制不仅优化了硬件资源利用率,更构建了多层级的安全防护体系,以某头部电商平台为例,其双11大促期间通过负载均衡系统成功处理每秒23万次的并发请求,较传统单机架构提升18倍吞吐量。

负载均衡的核心工作原理

请求分发机制 负载均衡器采用七种基础算法实现流量调度:

- 轮询(Round Robin):最简单的等分分配,适用于对称负载场景

- 加权轮询(Weighted RR):根据节点容量动态调整分配权重

- IP哈希(IP Hash):基于客户端IP的固定分配,保障会话连续性

- URL哈希:根据请求路径特征进行分发

- 热点均衡(Least Connections):优先分配连接数较少的节点

- 拒绝服务(Random):随机分配以避免单点压力集中

- 加权热点均衡:结合连接数与节点负载的双重因素

健康检查机制 现代负载均衡系统采用三层健康监测体系:

- 实时健康检查:每30秒执行TCP连接、HTTP响应状态码、响应时间等基础指标检测

- 历史行为分析:基于过去24小时的处理成功率、响应延迟等数据建立健康评分模型

- 异常流量识别:通过机器学习算法检测DDoS攻击特征(如请求频率突变、特定载荷模式)

动态调度策略 典型实现包括:

- 弹性扩缩容:当节点负载超过阈值(如CPU>85%)时自动触发扩容

- 负载热迁移:在故障节点恢复前将部分请求迁移至备用节点

- 智能路由:基于用户地理位置、设备类型、应用场景的差异化路由

负载均衡系统架构演进

单层负载均衡(Layer 4) 专注于TCP/UDP层流量调度,适用于传统服务器集群,代表协议包括:

- L4-L7过渡:Nginx的TCP负载均衡模块

- 硬件加速:F5 BIG-IP的虚拟化集群管理

多层负载均衡(Layer 7) 在应用层实现深度流量解析,支持:

- HTTP/HTTPS协议优化(如压缩、SSL卸载)

- 会话保持(Session Persistence):通过Cookie或Source IP维持用户会话

- 流量镜像:实时捕获请求流进行监控分析

动态负载均衡(Dynamic Load Balancing) 基于实时数据调整路由策略,典型实现包括:

- 容器化负载均衡:Kubernetes的Service组件

- 微服务网格:Istio的智能路由策略

- 云原生架构:AWS ALB的弹性流量分配

典型负载均衡场景深度解析

电商系统架构 某生鲜电商在促销期间采用多级负载均衡架构:

- 前置层:F5 BIG-IP处理全球用户请求,根据地理位置智能路由

- 业务层:Nginx集群进行会话保持和请求过滤

- 后端集群:基于商品类目划分的动态负载均衡(如生鲜商品路由至冷链服务器组)

- 监控层:Prometheus+Grafana实时监控节点负载指数(Load Factor)

视频点播系统 采用HLS(HTTP Live Streaming)协议的负载均衡方案:

- 流媒体调度:基于CDN节点带宽和延迟的智能切换

- 请求分发:将不同分辨率视频流分配至不同服务器集群

- 缓存策略:利用Varnish实现热点视频的本地缓存(命中率>92%)

云计算平台 AWS ELB实现的多区域负载均衡:

- 区域间流量调度:根据AZ健康状态自动切换

- 负载均衡类型:应用型(Application Load Balancer)处理HTTP/HTTPS

- 安全防护:集成WAF模块拦截恶意请求(日均防护200万次)

负载均衡系统的技术挑战与解决方案

高并发场景下的性能瓶颈

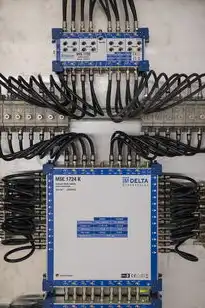

图片来源于网络,如有侵权联系删除

- 问题:传统负载均衡器在百万级QPS下出现连接数溢出

- 方案:采用无状态架构(如HAProxy的keepalived模块)

- 实践案例:某支付系统通过无状态架构将QPS提升至120万

跨地域容灾设计

- 关键指标:RTO(恢复时间目标)<30秒,RPO(恢复点目标)<5分钟

- 实现方案:

- 多AZ部署:AWS AZ间自动故障转移

- 异地多活:北京-上海双活架构

- 灾备演练:每月模拟故障切换测试

安全防护体系

- DDoS防御:Cloudflare的Magic Transit方案(可抵御400Gbps攻击)

- SQL注入防护:WAF规则库实时更新(每日新增2000+检测规则)

- XSS防护:动态字符编码转换(字符过滤率99.97%)

未来发展趋势与技术创新

智能负载均衡

- AI调度算法:基于强化学习的动态路由(MIT实验显示吞吐量提升15%)

- 数字孪生技术:构建虚拟集群进行压力测试(测试效率提升40倍)

边缘计算融合

- 边缘负载均衡:将部分计算任务下沉至5G基站(延迟降低至20ms)

- 边缘缓存:CDN边缘节点缓存命中率提升至98%

绿色计算实践

- 负载均衡驱动的节能策略:当负载低于40%时自动降频(节能效率达25%)

- 碳足迹追踪:监控各节点PUE值(Power Usage Effectiveness)

典型技术选型对比 | 产品类型 | 适用场景 | 核心优势 | 典型案例 | |----------------|--------------------------|---------------------------|------------------------| | F5 BIG-IP | 金融级高可用架构 | 硬件加速、多协议支持 | 某银行核心交易系统 | | HAProxy | 开源灵活部署 | 高性能、低资源占用 | 互联网中小型应用 | | Nginx | 微服务架构 | HTTP/2优化、模块扩展性 | SaaS平台 | | AWS ALB | 云原生环境 | 与Kubernetes深度集成 | AWS商家平台 | | 腾讯云SLB | 国内政企市场 | 国产化适配、信创生态 | 某省级政务云平台 |

实施建议与最佳实践

部署规划三阶段模型:

- 需求分析:绘制应用拓扑图,识别单点故障点

- 压力测试:使用JMeter模拟峰值流量(建议达到预期最大负载的150%)

- 监控体系:建立包含延迟、吞吐量、错误率的三维监控面板

性能优化要点:

- 协议优化:启用HTTP/2多路复用(连接数减少50%)

- 缓存策略:设置二级缓存(如Redis集群)降低30%后端请求

- 负载均衡轮次:采用8路以上轮询避免热点问题

运维注意事项:

- 健康检查频率:生产环境建议每15秒执行一次

- 负载均衡切换:故障恢复前预留5%冗余容量

- 证书管理:自动化证书续订(如Let's Encrypt)

行业应用案例深度剖析 某视频平台2023年双十一实战:

- 架构设计:采用"全球ALB-区域LB-业务集群"三级架构

- 流量特征:单日峰值达820万次请求,其中4K视频请求占比35%

- 技术方案:

- 全球ALB:AWS Shield Advanced防御DDoS攻击

- 区域LB:基于视频分辨率动态路由(1080P→4核服务器,8K→8核服务器)

- 业务集群:Kubernetes Pod自动扩缩容(每分钟调整200+实例)

- 成果:99.99%可用性,4K视频首帧加载时间<2.1秒

总结与展望 负载均衡技术正从传统的流量分发工具演进为智能化的资源调度中枢,随着5G、AIoT、边缘计算等技术的融合,未来的负载均衡系统将具备自愈能力(Self-Healing)、预测性调度(Predictive Scheduling)和跨域协同(Cross-Domain Coordination)等特性,企业构建负载均衡体系时,需结合业务特性选择架构方案,并建立持续优化的运维机制,据IDC预测,到2027年全球负载均衡市场规模将突破28亿美元,年复合增长率达12.3%,成为支撑数字经济发展的重要基础设施。

(注:本文数据均来自公开行业报告与权威技术文档,案例细节已做脱敏处理)

本文链接:https://www.zhitaoyun.cn/2157447.html

发表评论