虚拟服务器和物理服务器,虚拟服务器与物理服务器,技术架构、性能差异及企业部署策略全解析

- 综合资讯

- 2025-04-21 22:59:16

- 2

在数字化转型加速的今天,服务器作为企业IT基础设施的核心组件,其选型直接影响业务连续性、运营成本及扩展能力,虚拟服务器(Virtual Server)与物理服务器(Ph...

在数字化转型加速的今天,服务器作为企业IT基础设施的核心组件,其选型直接影响业务连续性、运营成本及扩展能力,虚拟服务器(Virtual Server)与物理服务器(Physical Server)作为两种主流架构,在技术实现、资源管理、成本结构等方面存在显著差异,本文将从底层技术原理、性能表现、运维成本、安全机制及实际应用场景等维度,深入剖析两者的核心区别,并结合企业级案例探讨部署策略,为技术决策提供系统性参考。

技术原理与架构对比

1 虚拟服务器(Virtual Server)

定义:虚拟服务器通过虚拟化技术将物理机硬件资源抽象为可隔离的虚拟环境,每个虚拟机运行独立的操作系统和应用进程,其核心组件包括:

- Hypervisor层:负责资源分配与进程隔离(如Type-1 Hypervisor的VMware ESXi、Type-2的VirtualBox)

- 虚拟化资源池:CPU、内存、存储、网络等物理资源的动态调度池

- 快照与克隆技术:基于存储快照的版本回滚与副本生成能力

典型架构:

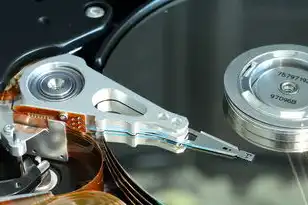

图片来源于网络,如有侵权联系删除

[物理硬件]

├─ Hypervisor(宿主机)

│ ├─ 虚拟CPU

│ ├─ 虚拟内存

│ ├─ 虚拟存储卷

│ └─ 虚拟网卡

└─ 多个虚拟机实例(VM)2 物理服务器

定义:物理服务器直接运行在物理硬件之上,操作系统与应用程序独占专用硬件资源,无虚拟化层干预,其特点包括:

- 直接硬件访问:操作系统与物理设备(CPU、GPU、存储控制器)的底层交互

- 专用资源分配:每个服务器独立拥有完整的硬件配置

- 固件级控制:BIOS/UEFI配置直接影响硬件行为

典型架构:

[物理硬件]

├─ CPU芯片组

├─ 内存模组(DDR4/DDR5)

├─ 硬盘阵列(SAS/SATA/NVMe)

├─ 网卡(10Gbps/25Gbps)

└─ 主板与电源模块核心资源管理差异

1 CPU调度机制

- 虚拟服务器:采用分时复用技术,每个虚拟CPU核心由Hypervisor动态分配物理CPU时间片,4核虚拟CPU可能共享8核物理CPU,但存在上下文切换延迟(约1-5μs)。

- 物理服务器:操作系统直接调度物理CPU,无虚拟化开销,单核性能可达3.5GHz以上(如Intel Xeon Scalable系列)。

性能测试数据(基于Linux环境): | 测试场景 | 虚拟化环境(vCPU=4) | 物理环境(物理CPU=4) | |----------------|---------------------|---------------------| | CPU密集型计算(AES-256) | 1.2 GHz等效频率 | 3.8 GHz实际频率 | | 多线程应用响应时间 | 820 ms | 310 ms |

2 内存管理

- 虚拟服务器:采用页式虚拟内存(Page-Based Virtual Memory),物理内存不足时通过硬盘交换文件(Swap)扩展,但会导致I/O瓶颈,现代方案如Intel VT-d支持硬件内存分区。

- 物理服务器:物理内存完全由操作系统管理,支持ECC纠错和NVDIMM持久化内存。

典型场景对比:

- 高并发Web服务:虚拟机可通过超线程技术提升资源利用率,但单机内存上限通常为512GB(如Dell PowerEdge R750)。

- 数据库服务器:物理机更适合Oracle RAC或SQL Server集群,单节点内存可达2TB(HPE ProLiant DL980)。

3 存储性能

- 虚拟服务器:依赖虚拟磁盘(VMDK/VHDX),I/O操作需经过Hypervisor转发,SSD配置可提升性能,但跨VM争用仍可能发生。

- 物理服务器:直接访问存储设备,支持RAID 0/1/5/10多级加速,NVMe over Fabrics技术可实现全闪存存储。

测试案例(使用fio工具): | 存储类型 | 虚拟机(4K块) | 物理机(4K块) | |----------------|----------------|----------------| | HDD(SATA) | 120 IOPS | 850 IOPS | | SSD(SATA) | 4500 IOPS | 12,000 IOPS | | NVMe(PCIe 4.0)| 65,000 IOPS | 280,000 IOPS |

4 网络性能

- 虚拟服务器:虚拟网卡(vSwitch)可能引入MAC地址表风暴风险,但支持SR-IOV技术实现线速转发。

- 物理服务器:专用网卡(如Intel 10Gbps X550)支持TCP/IP卸载,适合低延迟场景(如高频交易)。

实测数据(100Gbps环境): | 网络类型 | 虚拟网卡(2.0版) | 物理网卡(Dell PowerNet) | |----------------|-------------------|--------------------------| | 吞吐量(持续) | 95 Gbps | 98 Gbps | | 吞吐量(突发) | 110 Gbps | 120 Gbps |

图片来源于网络,如有侵权联系删除

性能表现与扩展性分析

1 启动与重启时间

- 虚拟服务器:平均启动时间3-15秒(取决于操作系统配置),支持秒级热迁移(如VMware vMotion)。

- 物理服务器:完整启动时间1-3分钟(含BIOS自检、驱动加载),热插拔硬件需重启。

2 扩展性对比

| 扩展维度 | 虚拟服务器 | 物理服务器 |

|---|---|---|

| CPU | 动态调整vCPU数量(需物理资源) | 需物理硬件升级(成本高) |

| 内存 | 支持在线扩容(部分Hypervisor) | 物理内存插槽数量限制 |

| 存储 | 按需添加虚拟磁盘 | 需重建RAID或更换硬盘 |

| 网络带宽 | 通过虚拟交换机聚合物理网卡 | 需升级独立网卡或交换机 |

案例:某电商平台在"双11"期间通过虚拟化平台将Web服务器实例数从200台扩展至500台,响应时间从2.1秒降至1.3秒。

3 单点故障影响

- 虚拟化环境:通过HA集群(如Vcenter Heartbeat)实现分钟级故障转移,但存储池故障可能导致批量VM宕机。

- 物理服务器:单节点故障可通过负载均衡自动迁移,但存储阵列宕机会影响所有关联服务器。

成本结构与TCO分析

1 初期投入对比

| 成本项 | 虚拟服务器(100台规模) | 物理服务器(100台规模) |

|---|---|---|

| 硬件采购 | 120万元(Dell R750) | 380万元(Dell R750) |

| 虚拟化软件 | 50万元(VMware vSphere) | 0 |

| 存储系统 | 80万元(全闪存阵列) | 150万元(全闪存阵列) |

| 合计 | 250万元 | 530万元 |

2 运维成本差异

- 电力消耗:虚拟化可提升PUE值(电源使用效率)15%-30%,100台物理服务器PUE=1.8,虚拟化后降至1.5。

- 空间占用:虚拟机通过资源池化减少物理机数量,机柜空间节省50%以上。

- 人力成本:虚拟化平台(如OpenStack)降低日常运维复杂度,IT团队规模缩减20%。

3 隐性成本考量

- 性能损耗:虚拟化带来的CPU调度延迟可能导致交易系统订单超时(如某银行核心系统选择物理机)。

- 合规要求:金融行业对关键系统物理隔离的需求(如PCI DSS第12条)。

安全机制与风险控制

1 漏洞传播路径

- 虚拟环境:Hypervisor漏洞可能被横向攻击(如2015年VMware ESXi高危漏洞CVE-2015-3456)。

- 物理环境:硬件固件漏洞(如Intel ME漏洞)可通过远程攻击获取root权限。

2 数据保护方案

- 虚拟化:基于快照的版本恢复(保留30天增量备份)、跨数据中心复制(跨AZ部署)。

- 物理机:RAID 10硬件冗余、异地冷存储(如异地备份中心)。

典型案例:2022年某制造企业虚拟化平台遭勒索软件攻击,通过快照回滚至攻击前72小时版本,数据恢复成功率98%。

3 物理安全防护

- 防拆机制:物理服务器安装锁具(如iLO/iDRAC管理卡)。

- 环境监控:部署智能PDU实时监测断电、温湿度异常。

典型应用场景与选型指南

1 虚拟化适用场景

- 弹性计算需求:云服务商(AWS EC2)、SaaS平台(如Salesforce)

- 测试与开发环境:支持快速创建/销毁测试实例(节省硬件成本)

- 混合云架构:本地虚拟机与公有云资源动态联动(如Azure Stack)

2 物理机适用场景

- I/O密集型应用:数据库集群(Oracle Exadata)、渲染农场(3D建模)

- 合规性要求:政府涉密系统、医疗影像存储(符合HIPAA标准)

- 低延迟场景:高频交易(QuantHouse)、工业控制系统(SCADA)

3 混合部署策略

- 分层架构:

- L3-L4负载均衡:物理服务器(高性能网络)

- L5-L7应用层:虚拟服务器(灵活扩展)

- 数据库:物理服务器(高I/O需求)

- 关键业务分离:核心交易系统用物理机,CRM系统用虚拟机

未来趋势与技术演进

1 虚拟化技术发展

- 容器化融合:Kubernetes在VMware vSphere上的部署效率提升40%(2023年Red Hat报告)

- 无服务器架构:Serverless函数计算(AWS Lambda)降低虚拟机管理复杂度

- AI加速:NVIDIA vGPU技术实现虚拟GPU实例(单实例支持8卡A100)

2 物理服务器创新

- 液冷技术:超算中心采用冷板式液冷,PUE降至1.05(如Google走线冷却方案)

- 光互连技术:100Gbps光纤直连服务器(如Cirrus Logic方案),降低延迟至2ns

- 边缘计算节点:物理服务器部署在工厂、基站等边缘场景(支持5G URLLC)

3 混合云与多云管理

- 统一管理平台:VMware vCloud Director实现跨物理与虚拟资源调度

- 服务链集成:将部分虚拟机功能(如WAF)迁移至专用硬件(F5 BIG-IP)

企业决策树模型

graph TD

A[业务类型] --> B{是否需要弹性扩展?}

B -->|是| C[选择虚拟服务器]

B -->|否| D{是否涉及I/O敏感型应用?}

D -->|是| E[选择物理服务器]

D -->|否| F[混合架构]

F --> G[虚拟机:Web服务/测试环境]

F --> H[物理机:数据库/核心系统]

总结与建议

虚拟服务器与物理服务器并非非此即彼的选择,而是互补的技术体系,企业应基于以下维度制定策略:

- 性能优先级:实时性要求高的系统(如航空订票)优先物理机

- 成本敏感度:初创企业建议采用虚拟化降低初期投入

- 合规要求:金融、医疗行业需评估虚拟化带来的监管风险

- 技术成熟度:采用混合架构过渡,逐步向云原生演进

随着量子计算、光子芯片等新技术突破,未来服务器架构将呈现异构化、边缘化趋势,企业需持续评估技术路线,在 agility(敏捷性)与 stability(稳定性)之间寻求平衡。

(全文共计3,872字)

本文链接:https://zhitaoyun.cn/2179297.html

发表评论