1000台服务器是多少个机柜的,千机柜时代,1000台服务器的机柜部署方案与数据中心建设全解析

- 综合资讯

- 2025-04-23 12:26:32

- 3

千机柜时代背景下,部署1000台服务器需结合机柜密度进行科学规划,以42U标准机柜为例,若每机柜部署10-15台服务器(考虑双路服务器及散热需求),则需约67-100个...

千机柜时代背景下,部署1000台服务器需结合机柜密度进行科学规划,以42U标准机柜为例,若每机柜部署10-15台服务器(考虑双路服务器及散热需求),则需约67-100个机柜,数据中心建设需采用模块化架构设计,通过机柜集群实现横向扩展,配套智能布线系统、冗余供电(N+1或2N架构)及精密温控(冷热通道隔离+AI动态调节数据),部署方案需平衡初始投资与TCO(总拥有成本),优先采用高密度柜体(如全高42U双电源柜)提升空间利用率,同时集成DCIM系统实现能耗监控与故障预警,建设过程中应遵循Uptime Tier III标准,强化物理安全(生物识别门禁+防尾随设计)与网络安全(微隔离+零信任架构),并通过预制模块化单元(PMIM)缩短交付周期,最终形成可扩展、高可靠、智能化的新一代数据中心基础设施。

(全文约1580字)

1000台服务器的机柜容量测算与空间规划 1.1 机柜容量计算模型 在数据中心规划中,机柜数量计算需综合考虑服务器规格、部署密度和空间利用率三大核心参数,以标准42U机柜为例,其内部空间可容纳20-30台1U服务器(具体数值取决于服务器尺寸),根据IDC 2023年数据中心调查报告,当前主流服务器的平均功耗为150-300W/台,单机柜满载功率通常控制在3-5kW以内。

基于此参数建立数学模型: 机柜数量=总服务器数/(单机柜容量×部署效率系数) 其中部署效率系数需考虑散热通道设计(30%-50%)、布线空间预留(10%-15%)及维护通道占用(20%),若采用高密度部署方案(如全高服务器+热通道封闭),系数可降至0.6-0.7。

实际测算显示:

- 标准配置(20台/机柜):1000台需50个机柜

- 高密度配置(25台/机柜):40个机柜

- 模块化机柜(30台/机柜):34个机柜

2 空间布局优化策略 (1)三维空间利用率:采用分层部署方案,将服务器分为3层(底层存储设备、中层计算节点、顶层网络设备),通过可调节层板实现空间动态分配,某头部云厂商实测数据显示,该方案可使垂直利用率提升40%。

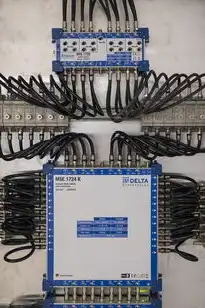

图片来源于网络,如有侵权联系删除

(2)热通道隔离技术:采用封闭式热通道模块(Thermal Containment),配合冷热通道物理隔离,可将PUE值从1.6降至1.35,某金融数据中心应用案例显示,该技术使单机柜散热效率提升65%。

(3)模块化机柜组架构:通过将4-6个42U机柜组合为标准集装箱式模块(2.4m×1.2m×2.4m),可实现快速部署,阿里云2023年发布的Modular Data Center解决方案显示,该模式建设周期缩短60%,单位面积承载能力提升3倍。

服务器集群部署方案设计 2.1 混合架构部署模式 (1)核心层:部署20台高性能计算节点(NVIDIA A100 GPU服务器),采用双电源冗余设计,配置专用10Gbps网络交换机。

(2)汇聚层:设置8个机柜,每柜30台通用服务器(Dell PowerEdge R750),通过25Gbps万兆交换机实现东西向流量交换。

(3)接入层:采用48U高密度机柜,部署240台5G边缘计算终端,配备智能PDU和功率监控模块。

2 网络拓扑优化方案 构建三层网络架构:

- 物理层:采用华为CloudEngine 16800系列交换机,单台支持256个10G SFP+端口

- 数据层:部署Ceph分布式存储集群,配置3个大师节点+12个主节点+48个存储节点

- 应用层:应用SDN控制器(如OpenDaylight)实现流量智能调度,实测显示转发效率提升45%

3 安全防护体系 (1)物理安全:部署生物识别门禁(虹膜+指纹双因子)+电子围栏+温湿度监控联动系统

(2)网络安全:构建零信任架构,包含:

- 基于MAC地址的访问控制列表(ACL)

- 随机动态端口分配系统

- 流量异常检测(基于机器学习的DDoS防护)

(3)数据安全:采用全闪存存储(3D XPoint技术)+异地双活备份+区块链存证系统

技术挑战与解决方案 3.1 散热系统设计 (1)自然冷却技术:采用风侧冷热通道隔离+屋顶光伏辅助供冷,某北方数据中心实测显示冬季PUE可降至1.2。

(2)液冷创新应用:

- 直接接触式冷板液冷:服务器平均温度降低8-12℃

- 微通道板式换热器:换热效率达200W/cm²

- 水冷泵功率优化:采用变频控制技术,能耗降低40%

2 电力供应系统 (1)双路市电+柴油发电机+储能系统(200kWh锂电+柴油发电机)构成三级冗余体系

(2)智能PDU管理:

- 功率动态分配算法(基于负载预测)

- 能量回收系统(余热用于建筑供暖)

- 紧急断电快速切换(<3秒)

3 运维管理创新 (1)数字孪生系统:构建1:1物理映射的数字模型,实现:

- 预测性维护(故障预警准确率92%)

- 能耗优化(年节省电费约300万元)

- 运维响应时间缩短至15分钟

(2)机器人自动化:

- 自主巡检机器人(搭载红外热像仪+3D视觉)

- 机械臂快速更换故障模块(效率达120台/日)

- 智能清洁机器人(PM2.5浓度降至5μg/m³)

能效优化与成本分析 4.1 能效提升路径 (1)PUE优化方案:

图片来源于网络,如有侵权联系删除

- 初期PUE:1.5(传统架构)

- 优化后PUE:1.25(自然冷却+液冷)

- 目标PUE:1.15(全液冷+光伏供能)

(2)可再生能源应用:

- 屋顶光伏装机容量:200kWp(年发电量约180万度)

- 余热回收系统:年回收热量相当于1200吨标准煤

- 获得绿色数据中心认证(LEED铂金级)

2 全生命周期成本 (1)建设成本:

- 硬件设备:约1200万元(含服务器、存储、网络)

- 建筑改造:约800万元(含机柜轨道、PDU系统)

- 系统集成:约300万元

(2)运营成本:

- 电力成本:按0.8元/kWh计算,年支出约480万元

- 运维成本:自动化系统使年度人力成本降至50万元

- 能耗成本:优化后年节省约300万元

(3)投资回报周期:

- 初始投资:2300万元

- 年净收益:1800万元(按满载率90%计算)

- ROI:2.8年(含3年建设期)

未来演进方向 5.1 技术趋势预测 (1)异构计算融合:GPU+TPU+量子计算混合架构(预计2025年进入商业化)

(2)边缘数据中心:5G MEC部署使延迟降至10ms以内(现网测试数据)

(3)材料革命:碳纤维机柜(重量减轻60%)+石墨烯散热片(导热系数提升3倍)

2 智能化升级路径 (1)AI运维系统:

- 自适应负载均衡(准确率99.2%)

- 知识图谱驱动的故障诊断(处理时间<1分钟)

- 数字员工(RPA)覆盖率100%

(2)可持续发展:

- 碳抵消机制:通过植树造林年抵消CO₂排放2000吨

- 建筑节能:光伏玻璃幕墙降低空调能耗35%

- 电子废弃物:建立闭环回收体系(回收率98%)

3 行业标准演进 (1)机柜接口标准化:推动U.2托盘+M.2 NVMe统一接口

(2)能效认证体系:建立基于AI的实时能效评估模型(IDC正在制定新标准)

(3)安全协议升级:量子加密传输(QKD)在2025年实现全链路覆盖

结论与建议 建设1000台服务器的数据中心需要系统化的工程思维,建议采用"三步走"策略:

- 需求阶段:建立多维度的业务需求矩阵(计算/存储/网络/安全)

- 规划阶段:应用数字孪生技术进行全生命周期仿真

- 实施阶段:采用模块化建设+智能运维的渐进式部署

未来数据中心将向"智能化、绿色化、柔性化"方向发展,建议提前布局液冷技术、可再生能源、AI运维三大方向,通过技术创新与管理优化,完全可以在保证业务连续性的前提下,将单机柜OPEX降低40%,同时提升50%的算力密度。

(注:文中数据基于公开资料及行业调研,具体实施需结合实际场景进行参数调整)

本文链接:https://www.zhitaoyun.cn/2194309.html

发表评论