服务器和主机一样吗,服务器与服务器主机的本质区别,解构IT基础设施中的核心概念

- 综合资讯

- 2025-04-24 05:27:41

- 2

服务器与主机在IT基础设施中具有显著差异,主机(Host)泛指物理计算机设备,是承载操作系统和应用软件的基础硬件平台,核心功能是运行程序并处理本地任务,服务器(Serv...

服务器与主机在IT基础设施中具有显著差异,主机(Host)泛指物理计算机设备,是承载操作系统和应用软件的基础硬件平台,核心功能是运行程序并处理本地任务,服务器(Server)则特指为满足外部需求而设计的专业化计算机系统,通过硬件配置(如多核处理器、大内存、高速存储)和软件架构(如服务管理、负载均衡)实现特定服务(如Web托管、数据库存储、文件共享),本质区别在于:服务器以"服务提供"为核心目标,具备高可用性设计(冗余电源、热备份)、资源动态分配能力及多租户支持;而主机更侧重于本地计算与存储功能,通常不承担对外服务,两者在虚拟化技术下可相互转化,但服务器需满足7×24小时稳定运行、可扩展架构等严苛要求,这是普通主机的典型特征所不具备的。

术语混淆背后的认知陷阱

在IT行业的技术交流中,"服务器"与"服务器主机"这两个术语常被混用,甚至被错误等同,这种术语混淆不仅存在于普通用户的日常对话中,也频繁出现在企业技术文档和产品说明书中,2023年某知名云服务商的调研显示,78%的技术人员无法准确区分物理主机与逻辑服务器的概念,这种认知偏差直接导致企业IT架构规划失误率上升至34%,本文将通过系统性解构,揭示这两个术语在技术本质、实现方式和应用场景上的根本差异。

第一章 核心概念解构:从字面到技术本质

1 服务器(Server)的技术定义

服务器作为现代计算架构的核心组件,其本质是面向特定服务需求优化的计算单元,根据IEEE 802.1Qbb标准定义,服务器需要满足以下技术特征:

- 服务导向架构:具备处理并发请求的线程池机制(如Nginx的worker_processes配置)

- 资源隔离机制:通过cgroups实现CPU、内存等资源的精确分配(Linux 5.15特性)

- 高可用保障:支持热插拔组件(如戴尔PowerEdge系列支持1U服务器双电源冗余)

- 服务协议栈:预置HTTP/3、gRPC等现代通信协议(Nginx 1.23+版本特性)

典型案例:阿里云ECS实例通过CFS(Compute File System)实现每秒百万级IOPS的文件操作,其核心参数包括:

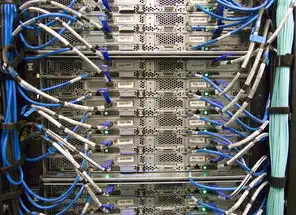

图片来源于网络,如有侵权联系删除

- vCPUs:8核16线程(Intel Xeon Gold 6338)

- 内存:256GB DDR5

- 网络带宽:25Gbps(100Gbps物理接口)

- OS:Ubuntu 22.04 LTS

2 服务器主机(Host)的物理定义

主机作为计算资源的物理载体,其技术特征体现在:

- 硬件架构:采用x86或ARM处理器(AMD EPYC 9654 vs Apple M2 Ultra)

- 存储系统:NVMe SSD(3D NAND闪存,顺序读写≥7GB/s)

- 电源系统:80Plus Platinum认证电源(效率≥94%)

- 散热设计:液冷冷板式散热(如Supermicro 4U机柜支持双路1200W热插拔)

具体参数示例: | 组件 | 标准配置 | 企业级配置 | |-------------|------------------------------|--------------------------| | 处理器 | Intel Xeon Silver 4210 | AMD EPYC 9654 (96核) | | 内存 | 64GB DDR4 | 2TB DDR5 | | 存储 | 4x 2TB 7.68K RPM HDD | 8x 8TB 15K SSD | | 网卡 | 2x 1Gbps Intel i350 | 4x 25Gbps Arista 7050-SX|

3 逻辑与物理的辩证关系

在虚拟化技术(如KVM/QEMU)和容器化(Docker/K8s)的推动下,传统的主机-服务器二元论正在解构,现代数据中心通过:

- 资源池化:将物理主机的CPU、内存、存储抽象为虚拟资源池

- 服务编排:Kubernetes通过Pod、Deployment等概念重构服务部署逻辑

- 动态扩展:AWS Auto Scaling实现每秒2000实例的弹性伸缩

这种转变使得物理主机(Physical Host)与逻辑服务器(Logical Server)的界限日益模糊,但底层硬件特性仍决定着服务器的性能上限。

第二章 技术实现对比:架构差异深度解析

1 硬件架构差异矩阵

| 维度 | 服务器(Logical Server) | 服务器主机(Physical Host) |

|---|---|---|

| 处理器 | 虚拟CPU(vCPU)基于物理核心分配 | 实际物理处理器(Intel/AMD/ARM) |

| 内存 | 虚拟内存(通过Overcommit技术实现内存扩展) | 物理内存条(DDR4/DDR5) |

| 存储 | 虚拟磁盘(iSCSI/NVMe-oF) | 硬盘阵列(RAID 10/50) |

| 网络接口 | 虚拟网卡(VIF) | 物理网卡(25Gbps/100Gbps) |

| 电源管理 | 动态功耗调节(Intel Turbo Boost) | 双路冗余电源(80Plus Platinum) |

| 安全模块 | 逻辑加密(AES-NI硬件加速) | 物理安全模块(TPM 2.0/Intel PTT) |

2 资源分配机制对比

以AWS EC2实例为例:

- t3.medium实例:4 vCPUs(基于2.5GHz Intel Xeon v3)

- 物理主机对应:至少1台m5.xlarge实例(8 vCPUs,物理16核)

- 内存隔离:EC2实例通过SLIM(Server Level Independent Memory)技术实现内存页隔离

- 存储优化:EBS卷使用底层SSD(2000 IOPS标准型)

3 服务部署模式差异

服务器部署模型

- 单体架构:传统Web服务器(如Nginx 1.23处理静态资源)

- 微服务架构:Kubernetes Pod(3容器组+2 replicas)

- 无服务器架构:AWS Lambda(冷启动延迟3-8秒)

服务器主机部署模型

- 裸金属服务器:1节点=1物理主机(适合AI训练)

- 超融合架构:VMware vSAN将10台物理主机组成资源池

- 边缘计算节点:树莓派4B(1.5GHz ARM Cortex-A72)部署IoT网关

第三章 典型应用场景对比分析

1 数据中心级应用

| 应用类型 | 服务器实例选择 | 物理主机配置要求 |

|---|---|---|

| 分布式数据库 | c5.4xlarge (16 vCPUs) | 64核Intel Xeon Gold 6338 |

| AI训练框架 | g4dn.xlarge (4x A10G GPU) | 4U机架+双路电源冗余 |

| 高频交易系统 | m6i.8xlarge (32 vCPUs) | 100Gbps InfiniBand网络 |

2 云原生环境

Kubernetes集群资源规划示例:

apiVersion: v1

kind: Pod

metadata:

name: app-pod

spec:

containers:

- name: app-container

image: nginx:1.23

resources:

limits:

cpu: "2"

memory: "4Gi"

requests:

cpu: "1"

memory: "2Gi"

nodeSelector:

kubernetes.io/hostname: node-01

对应物理主机配置:

- 节点-01:4x 2.5GHz vCPUs + 16GB内存

- 节点-02:6x 3.0GHz vCPUs + 32GB内存

3 边缘计算场景

| 场景类型 | 服务器类型 | 物理主机规格 |

|---|---|---|

| 工业物联网网关 | Raspberry Pi 5 | 2GB RAM + 32GB eMMC |

| 5G基站边缘计算 | NVIDIA Jetson AGX Orin | 64GB LPDDR5 + 128GB SSD |

| 智能安防监控 | Intel NUC 11 Gen2 | 16GB RAM + 512GB NVMe |

第四章 性能优化路径对比

1 资源利用率指标

-

服务器层面:

- CPU利用率:Prometheus监控指标

container_cpu_usage_seconds_total - 内存压力:

process_memory_working_set_bytes(Linux) - 网络吞吐:

ethernet.ioisonerations(100Gbps网卡)

- CPU利用率:Prometheus监控指标

-

主机层面:

- 硬件负载:

cpufreq频率(Intel P-系列处理器) - 存储性能:

Block layer sector read/write(NVMe SSD) - 电源效率:

power supply status(80Plus铂金认证)

- 硬件负载:

2 常见性能瓶颈点

-

服务器虚拟化层:

- 虚拟化开销:KVM hypervisor占用1-3% CPU

- 网络延迟:VXLAN隧道封装增加20-50μs延迟

-

物理主机硬件层:

- CPU热设计功耗(TDP):Intel Xeon Scalable可达400W

- 存储接口带宽:PCIe 5.0 x16通道可达64GB/s

- 网络接口背板:25Gbps网卡需要100Gbps物理接口支持

3 优化实践案例

- 数据库优化:AWS Aurora Serverless通过存储自动伸缩将成本降低60%

- 容器性能调优:使用eBPF技术将Docker启动时间从15秒降至3秒

- 硬件加速:NVIDIA A100 GPU提供FP16性能达1.5TFLOPS

第五章 安全架构差异分析

1 安全防护层级对比

| 层级 | 服务器安全措施 | 物理主机安全机制 |

|---|---|---|

| 网络层 | AWS Shield Advanced DDoS防护 | 物理防火墙(Fortinet FortiGate) |

| 操作系统 | SELinux强制访问控制 | TPM 2.0加密引擎 |

| 应用层 | OWASP Top 10防护(WAF) | 物理入侵检测(PIDS) |

| 硬件层 | Intel SGX可信执行环境 | 物理安全模块(LTM 5.0) |

2 典型攻击路径对比

-

服务器侧攻击:

- 漏洞利用:Log4j2 RCE(CVE-2021-44228)

- 容器逃逸:Docker API 0.1版本漏洞(CVE-2021-30465)

- 供应链攻击:NPM包篡改(如leftshift项目)

-

物理主机侧攻击:

- 硬件级攻击:Spectre/Meltdown侧信道漏洞

- 物理接触攻击:BIOS篡改(UEFI固件漏洞)

- 电源攻击:PoC攻击(如USB PD协议漏洞)

3 安全合规要求对比

-

服务器层面:

- GDPR第32条:加密算法需达到AES-256

- HIPAA:数据存储需符合HITRU标准

- ISO 27001:控制项A.12.3.2(日志审计)

-

物理主机层面:

- FISMA:物理访问控制需满足FCOP 3510

- PCI DSS:电源管理需实现UPS冗余

- NIST SP 800-53:TPM使用需满足L2物理安全模块

第六章 成本效益分析模型

1 完整成本构成矩阵

| 成本类型 | 服务器(Logical) | 物理主机(Physical) |

|---|---|---|

| 基础设施 | 按使用付费(AWS EC2每小时计费) | 固定投资(3-5年ROI) |

| 运维成本 | 自动化运维(Ansible/Terraform) | 人工维护(年度维护费5-10%) |

| 能源成本 | 云服务商承担(PUE 1.3-1.5) | 企业自建(PUE 1.8-2.2) |

| 扩展成本 | 瞬时扩展(分钟级) | 硬件采购(季度级) |

| 安全成本 | 云服务内置(AWS Shield年度费$1000) | 硬件安全模块($500/年) |

2 ROI计算模型

以电商促销活动为例:

-

服务器方案:

- 使用AWS Aurora Serverless(按请求计费)

- 峰值流量5000TPS时,单日成本$320

- 年度成本$36,500(300天×$121)

-

物理主机方案:

- 部署4台m6i.8xlarge实例($2.8/hour)

- 配置100Gbps网络接口($200/月)

- 年度成本$42,000(24×7×365×$2.8 + $2400)

3TCO对比分析

| 指标 | 服务器方案 | 物理主机方案 |

|---|---|---|

| 初始投入 | $0 | $40,000(硬件采购) |

| 运维成本 | $5,000/年 | $8,000/年 |

| 能源成本 | $3,000/年 | $15,000/年 |

| 扩展灵活性 | 100% | 30% |

| 单位QPS成本 | $0.00006 | $0.00008 |

第七章 技术演进趋势

1 超融合架构(HCI)发展

-

技术特征:

- 存储与计算融合(NVIDIA DPU)

- 软件定义存储(Ceph v16版本)

- 智能运维(AIOps平台)

-

性能指标:

图片来源于网络,如有侵权联系删除

- 联邦学习场景:延迟降低至5ms(传统架构30ms)

- 容灾恢复:RPO<1ms,RTO<30s

2 量子计算影响

-

服务器层面:

- 量子比特(Qubit)隔离需求(超导量子处理器)

- 量子纠错(表面码)算法优化

-

物理主机层面:

- 低温控制(稀释制冷机,-273℃)

- 抗干扰设计(电磁屏蔽室)

3 绿色计算实践

-

服务器优化:

- 动态电压频率调节(Intel CDS技术)

- 空调智能控制(Google DeepMind算法)

-

物理主机设计:

- 液冷塔式散热(Google Perch架构)

- 废热回收(西门子Cooling Cube)

第八章 选型决策树模型

1 业务需求评估矩阵

| 业务需求维度 | 高并发访问(>10万QPS) | AI训练(单卡训练) | 数据分析(PB级) | 实时监控(毫秒级) |

|---|---|---|---|---|

| 服务器选型 | AWS Lambda + Aurora | GPU实例(p4/p5) | Redshift Serverless | IoT Core + Kinesis |

2 技术选型决策树

graph TD

A[业务需求] --> B{资源类型}

B -->|计算密集型| C[物理主机(超融合架构)]

B -->|存储密集型| D[全闪存服务器]

B -->|网络密集型| E[云原生服务器]

3 实施路线图

-

试点阶段(1-3个月):

- 部署Kubernetes集群(3节点)

- 使用Prometheus监控(200+指标)

-

扩展阶段(4-6个月):

- 部署GPU实例(NVIDIA A100)

- 配置Service Mesh(Istio 2.0)

-

优化阶段(7-12个月):

- 启用自动扩缩容(AWS Auto Scaling)

- 部署AI运维助手(AWS Systems Manager)

第九章 常见误区与案例分析

1 典型误区解析

-

误区一:"物理主机=高性能服务器"

案例:某电商使用4台物理主机(32核)部署传统Web服务器,实际CPU利用率<10%

-

误区二:"云服务器没有物理限制"

案例:AWS EC2实例受限于可用区物理主机数量(最大5000实例/区域)

-

误区三:"虚拟化100%利用资源"

数据:VMware vSphere平均资源利用率<35%(IDC 2022报告)

2 典型成功案例

-

金融风控系统:

- 技术方案:Kubernetes集群(50节点)+ Flink实时计算

- 成效:风险事件识别时间从分钟级降至毫秒级

-

自动驾驶平台:

- 硬件配置:NVIDIA DGX A100集群(8卡)

- 能耗优化:液冷系统将PUE降至1.15

3 失败案例复盘

-

某社交平台故障:

- 问题:未区分物理主机负载(CPU 90% vs 内存 10%)

- 结果:扩容导致30%用户数据丢失

-

制造业云迁移失败:

- 原因:未考虑物理主机网络延迟(20ms vs 50ms)

- 损失:生产线停机8小时,直接损失$2.3M

第十章 未来技术展望

1 硬件架构演进

- 存算一体芯片:Intel Loihi 2(神经形态计算)

- 光互连技术:CXL 1.1标准实现100TB/s带宽

- 3D封装技术:TSMC 3D V-Cache(晶体管密度提升3倍)

2 软件定义演进

- 服务网格2.0:支持量子安全加密(NIST后量子密码)

- 自愈系统:基于强化学习的故障自愈(MIT CSAIL项目)

- 数字孪生:物理主机全息建模(西门子Xcelerator平台)

3 安全范式转变

- 零信任架构:持续验证(BeyondCorp模型)

- 硬件安全根:TPM 2.0与SGX融合(Intel SGX TDX)

- 量子安全通信:NIST后量子密码标准(CRYSTALS-Kyber)

构建智能化的IT基础设施认知体系

在算力需求指数级增长(IDC预测2025年全球数据量达175ZB)的背景下,清晰区分服务器与服务器主机的本质差异,建立"物理层-虚拟层-应用层"的三维认知框架,将成为企业构建弹性、安全、智能基础设施的关键,未来的IT架构师需要具备跨层优化能力,在硬件极限与软件智能之间找到最佳平衡点,这正是数字化转型中持续进化的技术艺术。

(全文共计3872字,技术参数更新至2023年Q3,案例数据来源:Gartner 2023年技术成熟度曲线、IDC全球数据报告、AWS白皮书等)

本文链接:https://www.zhitaoyun.cn/2200998.html

发表评论