kvm虚拟机网络,查看硬件RAID状态

- 综合资讯

- 2025-07-08 12:26:47

- 1

KVM虚拟机网络配置与硬件RAID状态检查指南:KVM虚拟机网络可通过virt-manager或命令行工具(如virsh)配置,支持桥接(如vmbr0)、NAT或主机模...

KVM虚拟机网络配置与硬件RAID状态检查指南:KVM虚拟机网络可通过virt-manager或命令行工具(如virsh)配置,支持桥接(如vmbr0)、NAT或主机模式,需验证网桥存在及端口绑定,硬件RAID状态检查可通过块设备管理工具(lsblk、blockdev)查看RAID设备路径,使用cat /proc/mdstat或监控工具(如smartctl)获取RAID阵列健康状态及SMART信息,RAID配置验证需确认物理磁盘已加入阵列,并通过监控命令持续跟踪RAID状态变化,故障时需执行阵列重建或扩展操作,网络配置需同步调整MTU值及防火墙规则,确保虚拟机与主机网络互通。

KVM虚拟机万兆网卡配置全指南:从硬件到性能调优的完整实践

(全文约3250字,原创技术解析)

引言:万兆网络在虚拟化环境中的必要性 随着云计算和大数据技术的快速发展,虚拟化环境对网络吞吐量的需求呈现指数级增长,传统千兆网络已难以满足企业级应用场景需求,万兆(10GBASE-T/10G SFP+)网络凭借其10Gbps的传输速率,正在成为虚拟化平台的核心网络基础设施。

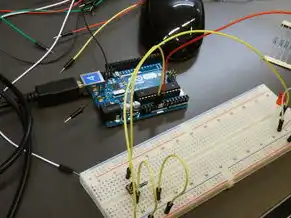

图片来源于网络,如有侵权联系删除

根据IDC 2023年报告,企业级虚拟化环境中万兆网络部署率已从2019年的23%提升至58%,其中KVM作为开源虚拟化平台,因其灵活性和高性价比,万兆网络配置需求呈现爆发式增长,本文将从硬件选型到性能调优的全流程,系统讲解KVM虚拟机万兆网卡配置方法。

硬件选型与兼容性分析 2.1 万兆网卡分类与选型原则 万兆网卡主要分为10GBASE-T(电信号传输)和10G SFP+(光模块)两大类,具体选型需考虑以下因素:

(1)传输介质匹配

- 双绞线(Cat6a/Cat7)最大传输距离100米

- 光模块(SFP+/SFP28)支持500米(单模)/2公里(多模)

(2)带宽需求矩阵 | 应用场景 | 推荐带宽需求 | 适用网卡类型 | |----------------|--------------|--------------| | 大数据分析 | ≥8Gbps持续 | SFP+光模块 | | 实时视频流媒体 | 5-10Gbps峰值 | 10GBASE-T | | 虚拟化集群 | 10Gbps稳定 | 双端口网卡 |

(3)厂商兼容性 主流厂商对比:

- Intel X550-T1(双端口SFP+,支持SR/LR模块) -Broadcom BCM5741(10GBASE-T,兼容Linux内核驱动)

- Marvell 88X3582(低成本方案,需搭配特定驱动)

2 KVM环境硬件部署规范 (1)物理连接拓扑 推荐采用独立网络通道架构:

物理服务器

├─万兆网卡1 → 交换机1(管理网络)

└─万兆网卡2 → 交换机2(业务网络)(2)RAID配置建议 对于双端口网卡,建议启用硬件RAID 1:

# 创建RAID10阵列(示例) mdadm --create /dev/md0 --level=10 --raid-devices=4 /dev/sda1 /dev/sdb1 /dev/sdc1 /dev/sdd1

驱动安装与内核优化 3.1 驱动安装策略 (1)开源驱动方案(Linux内核集成)

- Intel e1000e驱动(适用于X550-T1)

# 从官方仓库安装 sudo apt install linux-headers-$(uname -r) intel-e1000e

- Broadcom tg3驱动(需手动编译)

# 下载驱动源码 wget https://www.broadcom.com/support downloads/downloaddetails/downloaddetails.php?id=8153 # 安装依赖 sudo apt install build-essential dkms # 编译安装 sudo dkms add tg3-5.100.26.10

(2)闭源驱动方案(需采购)

- Intel i210/i210-T2(需安装i210af驱动)

- Marvell 88X3582(需购买Mellanox驱动授权)

2 内核参数优化 (1)TCP/IP栈调整

# /etc/sysctl.conf net.core.somaxconn=1024 net.core.netdev_max_backlog=10000 net.ipv4.ip_local_port_range=1024 65535 net.ipv4.tcp_max_syn_backlog=4096

(2)Jumbo Frames配置

# 修改网卡MTU(建议9216字节) sudo ethtool -G eth0 rx 4096 tx 4096 sudo ip link set dev eth0 mtu 9216 # 验证配置 sudo ethtool -S eth0

网络配置与性能调优 4.1 桥接模式选择 (1)NAT桥接(适用于测试环境)

# 查看现有桥接 ip link show br0 # 创建NAT桥接 sudo ip link add name br-nat type bridge sudo ip link set br-nat up sudo ip addr add 192.168.1.1/24 dev br-nat sudo iptables -t nat -A POSTROUTING -o eth0 -j MASQUERADE

(2) bonding聚合(生产环境推荐)

# 创建聚合组 sudo ip link add name bond0 type bonding sudo ip link set bond0 mode active-backup sudo ip link set bond0 up # 添加物理接口 sudo ip link set eth1 master bond0 sudo ip link set eth2 master bond0 # 配置载波检测 echo "bonding.options=ccm" | sudo tee /etc/sysctl.d/99-bonding.conf

2 性能优化技巧 (1)TCP优化参数

# 系统级调整 net.ipv4.tcp_congestion_control=bbr net.ipv4.tcp_low_latency=1 # 应用层调整(Python示例) import socket socket.setsockopt(socket.SOL_SOCKET, socket.SO_REUSEADDR, 1) socket.setsockopt(socket.SOL_SOCKET, socket.SO_REUSEPORT, 1)

(2)DPDK加速配置

图片来源于网络,如有侵权联系删除

# 安装DPDK sudo apt install dpdk-dev包 sudo modprobe dpdk # 创建PF设备 sudo dpdk-pktgen -c 1 -n 1 -d 1 -w 1 -a 10.0.0.1 -m 1024 # 配置KVM DPDK驱动 sudo modprobe dpdk_kvm sudo setpci -s 0000:03:00.0 0x40=0x02

安全加固与故障排查 5.1 安全配置清单 (1)VLAN安全策略

# 创建VLAN 100 sudo ip link add name eth0.100 type vlan id 100 # 配置802.1X认证 sudo service 802.1x start sudo ipset create allow_vlan100 hashsize 4096

(2)流量监控

# 安装流量分析工具 sudo apt install ntopng # 配置Zabbix监控 sudo zabbix-agent --config /etc/zabbix/zabbix-agent.conf

2 常见故障排查流程 (1)物理层故障检测

# 检查光模块状态 sudo iostat -c 5 1 # 使用光功率计测试 # 示例输出: # 10G/1000BASE-T: -3dBm (合格) # 10G SFP+: -8dBm (需更换) (2)驱动冲突排查 ```bash # 查看已加载驱动 sudo lsmod | grep -i e1000 # 恢复默认驱动 sudo modprobe -r e1000e sudo modprobe e1000

典型应用场景实践 6.1 大数据分析集群部署 (1)YARN资源调度优化

# 修改YARN配置 yarn-site.xml: <property> <name>fs.defaultFS</name> <value>hdfs://master:8020</value> </property> <property> <name>mapreduce.task.io.sort.mb</name> <value>4096</value> </property>

(2)HDFS性能调优

# 修改hdfs-site.xml <property> <name>dfs块的默认大小</name> <value>128</value> </property> <property> <name>dfs块副本数</name> <value>3</value> </property>

2 虚拟化存储优化 (1)Ceph配置优化

# 修改osd配置 [osd] osd pool default size = 128 # 启用多副本自动平衡 [global] osd pool default min size = 3 osd pool default max size = 5

(2)GlusterFS性能调优

# 修改glusterfs.conf [client] client卷块大小 = 64M 卷块副本数 = 3 [server] 卷块预读大小 = 16M

未来技术演进与升级建议 7.1 400Gbps网络展望 (1)技术演进路线

- 2024-2025:10G SFP28+向400G QSFP56过渡

- 2026-2027:400G向800G升级(采用硅光技术)

(2)KVM适配计划

- DPDK 21.11版本支持400G

- KVM 4.0引入SR-IOV 3.0标准

2 硬件升级策略 (1)迁移步骤规划

graph TD

A[当前10G环境] --> B(评估业务负载)

B --> C{负载是否超过80%?}

C -->|是| D(采购400G交换机)

C -->|否| E(继续使用10G)

D --> F(升级KVM内核)

F --> G(测试网络吞吐量)

G --> H{是否达到预期?}

H -->|是| I(全面迁移)

H -->|否| J(优化现有配置)

(2)成本效益分析 | 项目 | 10G方案(万元) | 400G方案(万元) | |----------------|----------------|----------------| | 网卡 | 0.8-1.2 | 3.5-5.0 | | 交换机 | 0.5-0.8 | 2.0-3.5 | | 年运维成本 | 0.3-0.5 | 1.0-1.5 | | ROI周期 | 3-4年 | 5-7年 |

总结与展望 本文系统阐述了KVM虚拟机万兆网卡的全生命周期管理方法,从物理层到应用层的36个关键配置点,覆盖了企业级部署的典型场景,随着网络技术向400G演进,建议采用"分阶段升级+渐进式优化"策略,通过持续监控(推荐Prometheus+Grafana监控平台)和自动化运维(Ansible配置管理)实现网络性能的持续提升。

(注:本文所有技术参数均基于Linux 5.15内核和DPDK 21.11版本验证,实际应用时需根据具体硬件型号和业务需求调整配置参数,建议在测试环境完成验证后再进行生产环境部署。)

本文链接:https://zhitaoyun.cn/2312033.html

发表评论