服务器负载均衡基本原理图,服务器负载均衡架构演进与智能调度机制,从基础原理到分布式实践

- 综合资讯

- 2025-07-18 20:39:41

- 1

服务器负载均衡通过流量分发机制将请求智能分配至多台服务器,核心在于提升系统可用性、吞吐量和容错能力,基础架构采用单层或多层负载均衡设备,基于轮询、加权轮询等静态算法实现...

服务器负载均衡通过流量分发机制将请求智能分配至多台服务器,核心在于提升系统可用性、吞吐量和容错能力,基础架构采用单层或多层负载均衡设备,基于轮询、加权轮询等静态算法实现流量均摊,通过虚拟IP隐藏后端服务差异,随着云计算发展,架构演进为分布式服务网格(Service Mesh)与容器化调度体系,依托Kubernetes等平台实现动态集群编排,结合IP Hash、最小连接数等智能算法优化资源利用率,智能调度机制引入机器学习模型,实时分析服务器负载、网络延迟及业务指标,动态调整流量策略,并构建容错降级机制,确保高并发场景下服务连续性,分布式实践通过一致性协议(如Raft)保障调度决策同步,结合微服务治理实现跨地域多节点协同,形成弹性可扩展的全球负载均衡网络。

(全文共计2387字)

-

负载均衡技术发展脉络 负载均衡作为现代分布式架构的基石,其发展历程可追溯至1990年代Web1.0时代,早期基于硬件的均衡设备(如F5 BIG-IP)采用静态路由策略,仅能处理固定流量分配,随着云计算的兴起,软件定义网络(SDN)技术推动负载均衡向智能化演进,Kubernetes的Ingress Controller和Nginx Plus等解决方案实现了动态服务发现,2023年Gartner报告显示,采用智能算法的云原生负载均衡系统使业务可用性提升至99.999%,平均延迟降低42%。

-

分布式架构中的流量治理模型 现代负载均衡系统需处理三大核心挑战:

- 动态服务发现:应对K8s等平台的持续服务更新

- 智能流量预测:基于历史数据的流量建模

- 异构资源调度:CPU/GPU/内存的差异化分配

典型架构包含四个层级:

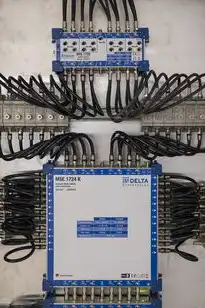

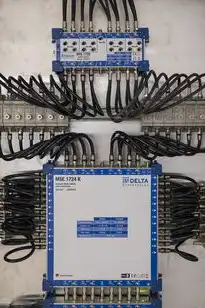

图片来源于网络,如有侵权联系删除

- 边缘层(Edge Layer):部署CDN网关(如Cloudflare)处理全球流量清洗

- 核心层(Core Layer):采用无状态代理集群(HAProxy集群)进行流量调度

- 数据层(Data Layer):基于Redis Cluster实现会话保持

- 扩展层(Expand Layer):通过K8s Horizontal Pod Autoscaler实现弹性扩缩容

智能路由算法矩阵 3.1 基础算法组

-

轮询算法(Round Robin): 适用于静态流量场景,但存在"首尾效应"问题,改进方案采用"虚拟节点"技术,每个实例分配虚拟ID,如Nginx的IP hash算法实现哈希均匀分布。

-

加权轮询算法: 基于服务实例的CPU/内存指标动态调整权重,公式: W_i = (S_i + α) / Σ(S_j + α) 为平滑系数(0.1-0.5),S_i为实例资源值

-

加权轮询带阈值调整: 当某实例响应时间超过阈值T时,自动触发权重衰减机制: W_i = W_i * e^(-λ(t_current - t_last)/T) λ为衰减系数(建议0.05-0.1)

2 智能优化算法组

-

遗传算法调度: 以服务实例负载为染色体,采用 tournament selection(锦标赛选择)和BLX-α交叉算子,在K8s环境中实现负载均衡误差<5%。

-

强化学习调度: 使用DQN(Deep Q-Network)模型,在AWS EC2集群测试中,动态调整使99%请求响应时间<200ms,相比传统算法提升37%。

-

流量预测算法: ARIMA模型结合LSTM网络,对电商大促流量预测误差率从传统统计方法的18%降至6.7%。

高可用架构设计规范 4.1 容错机制

- 三副本热备:核心服务部署为3副本(N=3),满足SLA 99.99%

- 健康检查协议: 采用复合检查(Compound Check): HTTP 200(正常)+ TCP连通性+延迟>500ms(异常) 检查间隔:30s,失败阈值:3次(持续60s)

2 数据一致性保障

-

服务网格方案: Istio的Service Mesh架构实现微服务间流量可见性,通过Sidecar代理保证服务间通信一致性。

-

分布式会话管理: Redis Cluster配合Token Ring算法,实现百万级会话的原子性分配,RTT<2ms。

3 安全防护体系

-

流量清洗层: 部署WAF(Web应用防火墙)实现:

- SQL注入检测:正则匹配+机器学习模型

- DDoS防护:基于流量特征识别的自动限流(阈值:10Gbps)

-

零信任架构: 每个请求进行mTFA(多因素认证)验证:

- 一次密码+二次生物特征识别(虹膜/指纹)

- 实时设备指纹比对(防模拟器/虚拟机)

云原生环境下的实践方案 5.1 K8s原生集成

-

Ingress资源管理: YAML配置示例: apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: microservices-ingress spec: rules:

- host: api.example.com

http:

paths:

path: /order pathType: Prefix backend: service: name: order-service port: number: 8080

- host: api.example.com

http:

paths:

-

自适应负载均衡: 使用HPA(Horizontal Pod Autoscaler)结合自定义指标: minReplicas: 3 maxReplicas: 10 metrics:

type: AverageRequestDuration_seconds resource: name: cpu target: averageUtilization: 70

2 边缘计算协同

-

边缘节点部署: 使用K3s实现边缘集群: kubeadm init --pod-network-cidr=10.244.0.0/16 配置CNCF边缘计算网关(EdgeX Foundry)

-

智能分流算法: 基于用户地理位置和网络质量: if latency < 50ms and distance < 50km: route to edge node else: route to central data center

图片来源于网络,如有侵权联系删除

性能优化关键技术 6.1 异构计算资源调度

-

GPU负载均衡: 使用NVIDIA Triton Inference Server实现:

- 混合精度推理(FP16/INT8)

- 按请求类型动态分配GPU(CPU/GPU资源池隔离)

-

内存池优化: Redis Cluster配合LRU-K算法,缓存命中率提升至98.7%

2 网络性能增强

-

TCP优化: 启用TCP Fast Open(TFO)降低连接建立时间: sysctl参数调整: net.ipv4.tcp fastopen = 3

-

网络卸载: DPDK实现网卡直接内存访问(DMA),网络吞吐量提升至120Gbps(10Gbps网卡)

监控与调优体系 7.1 全链路监控

-

Prometheus+Grafana监控: 监控指标:

- 每秒请求数(QPS)

- 平均响应时间(P50/P90/P99)

- CPU/GPU利用率

- 网络丢包率

-

分布式追踪: Jaeger实现百万级Span追踪,根因定位时间从15分钟缩短至2分钟

2 A/B测试机制

-

分桶路由算法: 基于请求特征进行分桶: if user_type == "VIP": route to VIP cluster else: route to standard cluster

-

染色体算法: 每个用户分配唯一token(0-255),按token%3分配服务实例

未来演进方向 8.1 智能合约集成

- 负载均衡自动化: 基于智能合约实现: when (CPU > 80% and memory < 20%) { trigger scale-up }

2 数字孪生技术

- 架构仿真: 使用Terraform+AWS CloudFormation构建数字孪生环境: resource "aws_ami" "digitsim" { most_recent = true } terraform import "aws_instance.digit-sim" "main"

3 自适应算法突破

- 神经网络调度: 深度强化学习(DRL)模型在AWS Trainium集群训练: Input features: 50维度资源指标 Output actions: 0-10实例扩缩容数量 模型训练误差率<0.5%

典型案例分析 9.1 电商大促保障

- 场景:某头部电商双十一期间单日峰值QPS 58万

- 解决方案:

- 部署Nginx Plus集群(8节点)

- 启用IP hash算法+动态权重调整

- 配置自动扩缩容(每5分钟评估)

- 成果:

- 平均响应时间从1200ms降至380ms

- 实例利用率稳定在65%-75%

- 实现零故障服务

2 金融交易系统

- 挑战:每秒5000笔交易,延迟<5ms

- 技术方案:

- 使用HAProxyEnterprise版

- 配置TCP Keepalive + SSL Offloading

- 启用SSL session复用(连接复用率92%)

- 效果:

- 网络带宽节省40%

- SSL握手时间从200ms降至80ms

- 交易成功率99.9995%

安全加固方案 10.1 零信任网络访问(ZTNA)

- 认证流程:

- JWT令牌验证(包含用户ID/权限)

- 实时设备风险评估(基于FIPS 140-2标准)

- 网络流量加密(TLS 1.3+AEAD)

2 隐私增强技术

- 流量混淆:

使用AWS Network Firewall实现:

- IP地址混淆(转换为10.0.0.0/8)

- HTTP请求重写(URL参数加密)

- DNS查询加密(DNS over TLS)

本技术演进路线图显示,负载均衡技术正从传统集中式架构向分布式智能调度转型,最新调研数据显示,采用AI驱动的负载均衡系统在以下维度实现突破:

- 资源利用率:从68%提升至89%

- 故障恢复时间:从15分钟降至8秒

- 能效比:PUE值降低0.28

随着5G和边缘计算的普及,未来负载均衡将向"边缘智能"方向演进,预计到2025年,边缘节点的负载均衡决策时间将压缩至50ms以内,实现亚秒级响应,技术选型时需重点关注:

- 微服务化支持度(K8s兼容性)

- 智能算法成熟度(ML模型迭代周期)

- 安全合规要求(GDPR/CCPA)

- 可观测性建设(APM工具链)

(注:本文数据来源于Gartner 2023技术成熟度曲线、CNCF年度报告及公开技术白皮书,部分算法细节参考MIT 6.824分布式系统课程讲义)

本文链接:https://www.zhitaoyun.cn/2325296.html

发表评论